Desafíos del fact-checking frente al desarrollo de la inteligencia artificial

- En las últimas semanas se habló mucho sobre la inteligencia artificial (IA) y la creación de contenido falso utilizando herramientas con esta tecnología. Pero, los fact-checkers afrontan esta realidad desde hace varios años.

- Los investigadores de OpenAI (la empresa que desarrolló Chat GPT) en colaboración con el Centro de Seguridad y Tecnología Emergente de la Universidad de Georgetown y el Observatorio de Internet de Stanford publicó un informe, en el que advierte que la IA puede utilizarse para activar mecanismos (como la desinformación) de influencia en las personas y por lo tanto supone nuevos retos para los fact-checkers.

- Una de las experiencias más interesantes del uso de la IA al servicio del fact-checking es la de Newtral, un medio de comunicación español que desarrolló herramientas para procesos de verificación de contenidos.

Por Enid López

La inteligencia artificial (IA) es la capacidad que tienen “las máquinas” de usar algoritmos, “aprender” datos y utilizar esa información para “tomar decisiones” tal como lo haría un ser humano[1]. El desarrollo acelerado de este tipo de tecnología hizo que los fact-checkers se pregunten si se trata del inicio de una nueva era de herramientas que apoyen la creación de la desinformación y a la vez que ayuden en el trabajo de verificación.

En las últimas semanas se habló mucho sobre la inteligencia artificial y la creación de contenido falso utilizando herramientas con esta tecnología. Pero, los fact-checkers afrontan esta realidad desde hace varios años verificando las famosas “deepfakes”.

La tecnología deepfake[2] se refiere al uso de la IA para crear imágenes, audios y videos falsos, pero altamente convincentes. Compuesta por dos palabras, fake (falso) y deep de deeplearning (aprendizaje profundo). Puede ver acá más información para identificar una deepfake.

Uno de los casos más famosos de este tipo, circuló en 2019. Se trataba de un video en el que aparecía el mismo Mark Zuckerberg diciendo: "Imagina esto por un segundo: un hombre, con el control total de los datos robados de miles de millones de personas, todos sus secretos, sus vidas, sus futuros". Por supuesto que se trataba de desinformación, pero puso en vilo a Facebook e Instagram, las dos plataformas donde se distribuía el video de forma masiva.

La IA volvió a ser un tema de conversación tras los avances de la tecnología Generative Pre-trained Transformer (GPT), con el famoso Chat GPT, un prototipo de chatbot, lanzado el 30 de noviembre de 2022 como una versión mejorada de GPT-3. Pero una nueva ola de comentarios surgió tras el reciente lanzamiento de GPT-4, el 14 de marzo de 2023. Se trata de un avance significativo presentado por OpenAI, una compañía que investiga los avances de la inteligencia artificial y se anuncia sin fines de lucro.

Si bien la desinformación ha existido desde el origen de la humanidad, los avances de la tecnología son los que inciden en su distribución y creación masiva. Pero, ¿Cómo podría incidir la IA en el trabajo de los fact-checkers?

Los investigadores de OpenAI (la empresa que desarrolló Chat GPT) en colaboración con el Centro de Seguridad y Tecnología Emergente de la Universidad de Georgetown y el Observatorio de Internet de Stanford publicó un informe, en el que advierte que la IA puede utilizarse para activar mecanismos (como la desinformación) de influencia en las personas y por lo tanto supone nuevos retos para los fact-checkers. Este informe es el resultado de un taller en octubre de 2021 que reunió a 30 investigadores de desinformación, expertos en aprendizaje automático y analistas políticos.

“Nuestro juicio final es que los modelos de lenguaje serán útiles para los propagandistas (que podrían ser desinformantes) y probablemente transformarán las operaciones de influencia en línea. Incluso si los modelos más avanzados se mantienen en privado o se controlan a través del acceso a la Interfaz de Programación de Aplicaciones (API), los propagandistas probablemente gravitarán hacia alternativas de código abierto”, señala el informe.

Según esta investigación, la tecnología impulsada por modelos de lenguaje como la IA afecta en tres facetas y se conoce como el modelo ABC (actors, behavior y contend), que traducidos del inglés serían actores, comportamiento y contenido, como se observa a continuación:

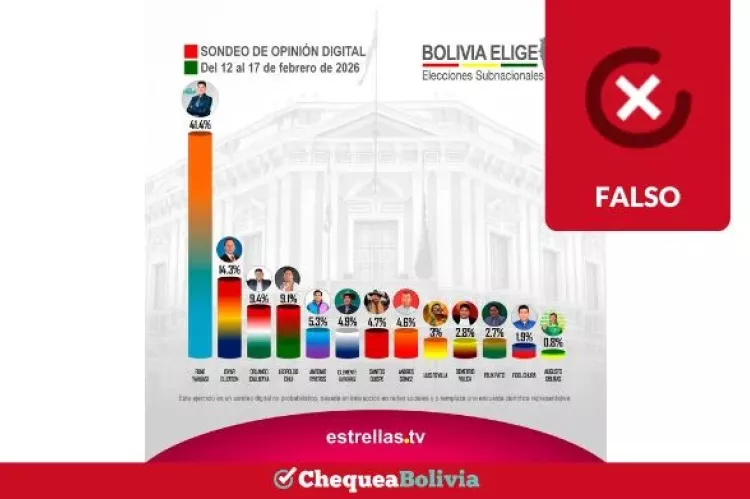

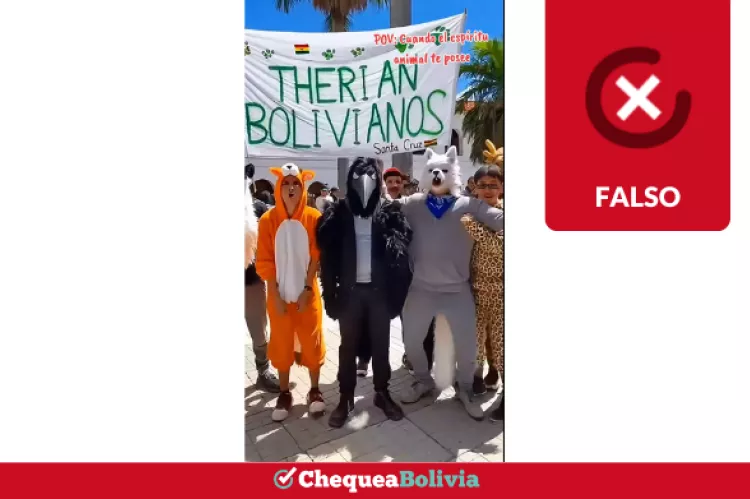

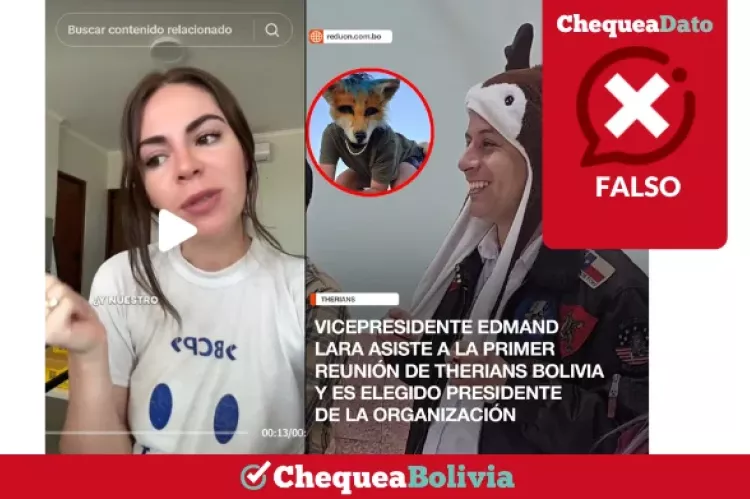

ChequeaBolivia verificó recientemente contenidos creados con IA. “Se viene una sesión del Papa con Bizarrap”, “el argentino con más flow”, comentaron los internautas en uno de los contenidos verificados Se trata de las imágenes falsas del Papa Francisco creadas con IA. Herramientas como Chat GPT, los simuladores de imágenes e incluso los suplantadores de voz han popularizado el uso de este término.

Sobre los modelos de chats y desinformación

El pasado 5 de abril, Juan Gómez Romero, profesor de la Universida de Granada, alertó a través de su cuenta de Twitter, que Chat GPT le brindó información sobre un supuesto desmentido de Maldita (iniciativa de verificación de España) que ni la desinformación ni el enlace que le proporcionó eran reales.

“He pedido a ChatGPT que me muestre algún desmentido destacado de Maldita. La respuesta es formalmente perfecta. Lo interesante es que el bulo “vacuna o guillotina” nunca ha existido, ni tampoco la verificación que enlaza”, indicó a tiempos de clarar que lo consultó a la versión 3.5. Más tarde un usuario le comentó y le dijo que le hizo la misma consulta a la versión ChatGPT-4.0 y recibió información coherente y verás.

En la investigación de OpenAI, se advierte que los modelos de lenguaje que participan en conversaciones de ida y vuelta, podrían ser modelos de influencia implementados por bots para chats personalizados. “Hay razones para pensar que el chat puede ser un importante vector de influencia. Los investigadores ya han descubierto que interactuar con un bot conversacional puede influir en las intenciones de las personas de vacunarse contra el COVID-19 con los bots conversacionales basados en modelos de lenguaje, estas interacciones podrían ser aún más poderosas”, señala.

Italia se convirtió en el primer país en rechazar este programa de IA ChatGPT. El Garante italiano para la Protección de Datos Personales, una autoridad administrativa independiente que vela por la protección de datos de los usuarios y consumidores, explicó que la plataforma recoge datos de los usuarios de manera ilegal.

Cuáles son las desventajas de la IA para los fact-checkers

1.- Menos costo y mayor automatización

La IA reduce los costos para impulsar campañas “propagandistas”, ya que permite crear contenido de forma automatizada, se reducen los costos de creación de personajes. “Estos desarrollos ampliarán el conjunto de actores con capacidad para ejecutar operaciones de influencia”, señala la investigación de OpenAI.

2.- Mayor alcance

Al existir mayor automatización para la creación de contenidos. Esta situación, permite la difusión automatizada de mensajes en proporciones mayores a las que realizan los bots (usuario automatizado) o trolls (usuario real), por tanto existe mayor alcance.

3.- Mayor sofisticación

Los mensajes que se elaboran con inteligencia artificial, fácilmente pueden pasar como si hubieran sido elaboradas por humanos. Entre otras técnicas, la IA puede poner a prueba un contenido en una plataforma para medir el alcance, antes de su distribución masiva en otras plataformas. También, se constituyen en “actores manipuladores”, ya que pueden abrumar o falsificar controles, utilizando modelos de lenguaje en espacios para realizar comentarios.

La IA basada en machine learning como aliada para los fact-checkers: la experiencia de Newtral

Se podría continuar enumerando la cantidad de desventajas de la IA para los fact-checkers, pero también es importante mencionar que se constituye en una herramienta muy potente para optimizar procesos de trabajo que pueden automatizarse. En ese sentido, una de las experiencias más interesantes es la de Newtral, un medio de comunicación español que desarrolló herramientas con inteligencia artificial (IA) para procesos de verificación de contenidos.

El machine learnig- aprendizaje automático[3], es una parte de la IA que permite que las máquinas aprendan y sean capaces de identificar patrones en los datos. Se utilizó este término por primera vez, en 1959.

Irene Larraz, periodista de Newtral, en contacto con ChequeaBolivia indicó cómo se utilizan herramientas desarrolladas con inteligencia artificial para ayudar a los fact-checker y ahorrar más tiempo para destinarlo a la lucha contra la desinformación.

Una de las herramientas desarrolladas con IA se denomina ClaimDetection, que ayuda al monitoreo del discurso público y permite detectar posibles declaraciones verificables. “Lo que hacemos es leer todo el discurso, revisar si el algoritmo ha hecho bien la selección de frases verificables, revisar si ha dejado algo subrayamos nosotros y si ha marcado algo que no es verificable, lo eliminamos. Luego de la selección que hace el algoritmo, nosotros hacemos el filtrado y vemos cuáles son las frases relevantes, descartamos las frases que son ciertas y que no tienen mucho valor para la verificación y elegimos solo las que nos interesa contrastar los datos”, explicó Larraz.

Una segunda herramienta que desarrolló Newtral se llama ClaimHunter, que permite nutrir al algoritmo con aproximadamente 1500 cuentas de Twitter de políticos, no solo de España, sino de Latinoamérica debido a alianzas con otras iniciativas de verificación de esta región.

“Lo que hace este algoritmo es que de todas las declaraciones que hacen los políticos en Twitter selecciona solamente las que son verificables. A partir de eso, nosotros vamos anotando y vemos: ‘esta sí es verificable, pero no relevante porque es un dato que salió hoy y sabemos que es cierto; esta sí es relevante, entonces me interesa revisarla bien, echarle un ojo y ver si es cierto’”, añadió Larraz.

Este medio de comunicación de España, en alianza con periodistas de Italia desarrolló una tercera herramienta que se llama ClaimCheck y permite detectar cuándo se repite una desinformación. El sistema

funciona con alertas para los verificadores indicándoles cuando una posible desinformación ya fue verificada.

¿La IA reemplazará a los fact-checkers?

Para David Dieudonné, líder de Google News Lab en Francia, Italia y España: “Entre más trabajas con inteligencia artificial, más compruebas que el valor de los periodistas no es reemplazable. Todo el tiempo que ellos se ahorran gracias a estas herramientas es más tiempo para agregar ese valor a su trabajo”.

Irene Larraz considera que no es factible que estos sistemas reemplacen el trabajo periodístico. “Son herramientas que nos permiten trabajar, pero siempre es el humano en el centro de todos estos desarrollos. Están ahí para facilitarle la tarea a la persona, no para quitársela ni que sea innecesario su trabajo”, afirmó.

En algunos medios bolivianos como Opinión, un diario de Cochabamba - Bolivia, se experimentaron contenidos con avatares para presentar información en videos breves, como se observa a continuación.

Si bien los modelos de inteligencia artificial se utilizan para generar desinformación al grado de convertirse en estafas, también se constituye en una herramienta poderosa para acortar procesos de la verificación de contenidos, donde el periodista sigue siendo el protagonista para la contrastación de fuentes. Se trata de un tema que está en constante evolución y que continuará dando sorpresas en los próximos meses.

Fuentes:

Informe de OpenAI (la empresa que desarrolló Chat GPT) en colaboración con el Centro de Seguridad y Tecnología Emergente de la Universidad de Georgetown y el Observatorio de Internet de Stanford.

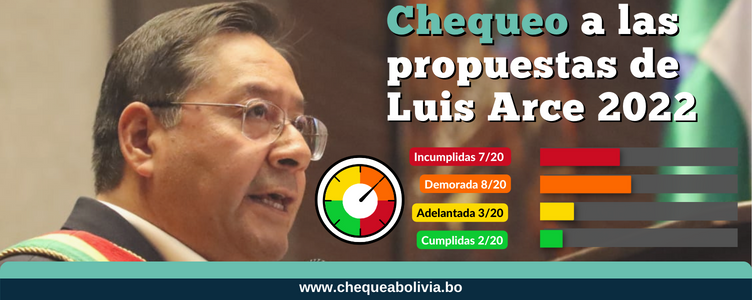

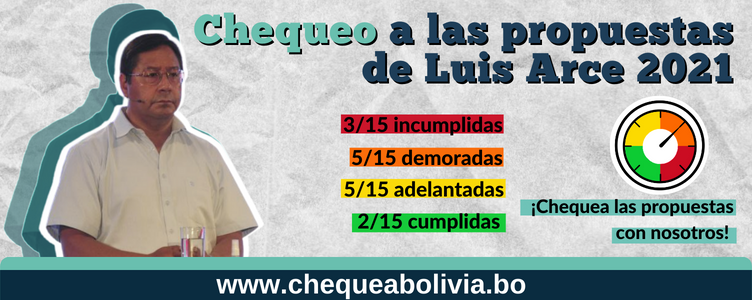

Verificaciones de ChequeaBolivia

Cuenta de Twitter del profesor de la Universidad de Granada, Juan Gómez

Irene Larraz, periodista de Newtral

David Dieudonné, líder de Google News Lab en Francia, Italia y España, citado en Fundación Gabo

Massachusetts Institute of Technology School of Architecture + Planning

Notas al pie

[1] Lasse Rouhiainen en su texto “Inteligencia artificial. 101 cosas que debes saber hoy sobre nuestro futuro”, publicado en 2018.

[2] “The People Onscreen Are Fake. The Disinformation Is Real”, artículo publicado en The New York Times.

[3] “Machine learning': ¿qué es y cómo funciona?”, publicado por la BBVA en noviembre de 2019 e “Inteligencia artificial : definición, historia, usos, peligros”, publicado por DataScientest en agosto de 2022.

Tendencia Política

- Log in to post comments